Lichtlaufzeitmessung (ToF): 3D-Aufgaben und deren Bewältigung

Wir haben Sie in unserer Reihe von 3D-Bildverarbeitungsblogs bereits in einige der bekanntesten Technologien eingeführt, die in der Bildverarbeitung Anwendung finden (Stereovision, Lichtlaufzeitmessung, strukturiertes Licht und 3D-Lasertriangulation).

In diesem Blog-Beitrag werden wir uns mit Time-of-Flight (ToF) befassen und die Technologie im Detail untersuchen und herausfinden, wie sie gerade mit dieser Technologie Anwendungen in der 3D-Bildverarbeitung lösen können.

Was ist Time of Flight alias Lichtlaufzeitmessung (ToF)?

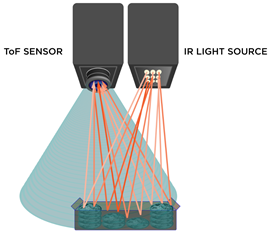

Die Time-of-Flight Bildgebungstechnik ermöglicht die 3D-Erfassung ohne ein Objekt abscannen zu müssen. Dieser Ansatz beruht auf der Beleuchtung eines Objekts mit einer modulierten Lichtquelle. Die Position des Objekts wird dann durch die Laufzeit eines vom Sender gesendeten pulsbasierten Lichts und dessen Rückkehr zum Sensor (Empfänger) bestimmt, nachdem es von einem Objekt reflektiert wurde. Daher der Name Lichtlaufzeitmessung.

Revolutionäre Lichtlaufzeitsensoren

In der Vergangenheit hat Time-of-Flight Fragen zu seiner Genauigkeit aufgeworfen und wurde allgemein als ungenaue 3D-Technologie mit begrenzten Einsatzmöglichkeiten angesehen. Ältere Sensorgenerationen lieferten lediglich Genauigkeiten von 1-2 cm.

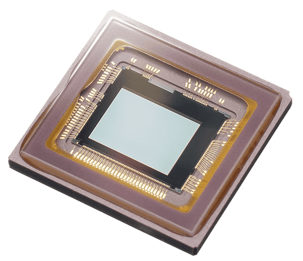

Die DepthSense ToF-Sensoren von Sony haben jedoch die Technologie revolutioniert und bieten Genauigkeit auf den Millimeter genau. Für Systemintegratoren, die mit feineren Genauigkeitsgraden arbeiten, bedeutet dies kein Ratespiel mehr.

Der IMX556 DepthSense ToF-Sensor verfügt über CAPD- und BSI-Technologie (Backside Illuminated/ Rückseitige Beleuchtung) - Technologien, die im Vergleich zu bestehenden ToF-Lösungen auf dem Markt eine überlegene Tiefenpräzision erzielen.

Sony IMX556 DepthSense Sensor

Die Bestandteile der Time of Flight Kamera

ToF 3D-Kameras umfassen ein Objektiv, eine integrierte Lichtquelle, einen Sensor, der alle erfassten Bildinformationen speichert, und eine Schnittstelle. Während alle modernen Bildgebungssysteme Sensoren, Linsen, Schnittstellen und häufig Beleuchtungsmodule enthalten, ist dieser Ansatz anders. Das Herzstück einer Lichtlaufzeitkamera ist der Sensor und die IR-Lichtquelle, die harmonisch zusammenarbeiten, um den Abstand zwischen Sensor und Objekt zu messen. Infolgedessen kann dieses System sowohl Tiefen- als auch Intensitätsinformationen gleichzeitig für jedes Pixel im Bild erfassen.

Time-of-Flight-Kameras bieten ein großes Potenzial für Bildverarbeitungsanwendungen, da sie nativ die Tiefeninformationen erfassen, die von herkömmlichen Bildgebungssystemen abgeleitet werden müssen.

Da diese Tiefeninformationen unabhängig von Intensität und Objektfarbe sind, können Sie das Objekt mit relativ einfachen Algorithmen vom Hintergrund trennen.

Vor- und Nachteile von Time of Flight

ToF-Kameras sind aufgrund einer Reihe von Vorteilen gegenüber anderen 3D-Techniken eine attraktive Lösung für eine Vielzahl von Bildverarbeitungsanwendungen.

Erstens bedeutet die kompakte Bauweise, dass ToF-Kameras mit weniger Aufwand als andere 3D-Bildgebungstechniken eingesetzt werden können, was Zeit und damit Geld spart. Time-of-Flight ist schnell, einfach zu installieren und bei weitem die billigste 3D-Kameratechnologie im Vergleich zu Stereovision und 3D-Lasertriangulation. Die Einschränkung besteht jedoch darin, dass die Lichtlaufzeitmessung nicht so genau ist wie bei anderen 3D-Technologien wie zbsp. der 3D-Lasertriangulation.

Time-of-Flight Kameras bieten außerdem eine hohe Genauigkeit und Tiefenauflösung im Millimeterbereich sowie hervorragende Bildraten von etwa 60 Hz, sodass ToF sowohl mit sich bewegenden als auch mit statischen Objekten umgehen kann.

In Bezug auf Überlegungen ist es wichtig zu beachten, dass dies zwar kein 3D-Scanner ist, es sich jedoch um eine aktive Form der 3D-Technologie wie Lasertriangulation oder Stereovision handelt und es etwas schwieriger ist, die richtige Beleuchtungsquelle zu finden, wenn Sie sich für einen Selbstaufbau entscheiden.

Die Präzision der gepulsten IR-Lichtquelle ist der Schlüssel zur Gewährleistung genauer Messungen. Die Impulse müssen sowohl in der Anstiegs- als auch in der Abfallzeit die gleiche Dauer haben, da das System sehr empfindlich auf Schwankungen reagiert. Selbst eine Nanosekundenabweichung zwischen Impulsen kann in realen Einheiten zu Fehlern von Zentimetern führen.

Die Faktoren, die die Genauigkeit der 3D-Rekonstruktion beeinflussen, variieren von Mehrfachreflexionen, Streulicht, Arbeitsbereich, Temperatur, Transparenz und Umgebungslicht. Um Fehler zu vermeiden, wird empfohlen, in der Mitte des Arbeitsbereichs zu messen und zu vermeiden, in Bereichen mit Mehrfachreflexionen oder wechselndem Umgebungslicht zu arbeiten.

Eine stabile Position und die Verwendung von Rauschfiltern für Raum und Zeit tragen dazu bei, die Genauigkeit des Systems zu erhöhen. Die Technologie hat einen großen Vorteil bei Umgebungen mit wenig Licht, da die erzielten Ergebnisse weniger Umgebungsschwankungen ausgesetzt sind, was sich in einer Verbesserung der Genauigkeit niederschlägt.

Die Auswahl der richtigen Lichtlaufzeitkamera

Für eine großartige All-in-One Time-of-Flight Kamera empfehlen wir die Helios-Serie von LUCID Vision Labs. Diese besteht aus dem Original Helios, Helios2 und dem kompakten und anpassungsfähigen Helios Flex-Kameramodul, das für minimalste Platzverhältnisse entwickelt und für NVIDIA Jetson TX2 optimiert wurde.

LUCID Helios2

Die Helios2 Time-of-Flight Kamera (ToF) ist eine IP67 3D-Kamera mit dem IMX556PLR DepthSense-Sensor von Sony, der für den Hochleistungsbetrieb in industriellen Umgebungen entwickelt wurde. Entwickelt für anspruchsvollste 24/7 Umgebungen und eine Vielzahl industrieller 3D-Anwendungen wie Robotik, 3D-Inspektion und Logistik, einschließlich fortschrittlicher Materialhandhabung, Bestückung, Sortierung, Palettierung und Entpalettierung, Volumetrische Messungen und viele mehr.

Die Helios2 bietet im Vergleich zum vorherigen Helios Modell eine Präzision von weniger als einem Millimeter und eine verbesserte Genauigkeit. Die Kalibrierung zwischen den VCSELs und dem Sensor-Timing wurde nochmals verbessert, was zu mehr 3D-Details sowie einer verbesserten Kantenerkennung führt, um fliegende Bildpunkte und das allgemeine Rauschen zu reduzieren.

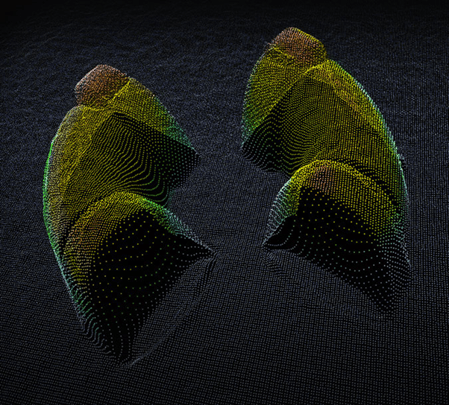

Die Kameras von LUCID funktionieren perfekt zusammen mit der Arena SDK-Software für die Bildverarbeitung und das Rendern von Punktwolken. Wenn Sie Matrox Design Assistant (DA) oder Matrox Imagine Library (MIL X) bevorzugen, unterstützen beide Programme die Helios-Reihe von LUCID.

Punktwolke mit Helios2 erfasst und mit Arena SDK generiert

Weitere Informationen zu den oben genannten Themen finden Sie in unserem informativen E-Book zu 3D-Bildgebungstechniken. Spezifikationen für verschiedene 3D-Bildgebungslösungen finden Sie in den Datenblättern unserer Kameras, die auf unserer Website verfügbar sind, um Ihnen bei der Auswahl des optimalen 3D-Bildverarbeitungskameramodells für Ihre industrielle Anwendung zu helfen.